Blog

Ce que vous devez savoir sur les évaluations de conformité selon le règlement de l’UE sur l’IA

Qu’est-ce qu’une évaluation de conformité ? Qui en est responsable et pourquoi sont-elles importantes ? Comprenez ces évaluations et leur lien avec votre programme de gouvernance de l’IA.

Lauren Diethelm

AI Content Marketing Specialist

20 novembre 2023

Le règlement de l’UE sur l’IA adopte une approche de l’IA prudente et basée sur les risques. Elle définit quatre catégories de risques différentes dans lesquelles les systèmes d’IA peuvent être classés. Ces catégories de risques sont conçues pour protéger la santé, la sécurité et les droits humains fondamentaux de tout individu en contact avec les systèmes d’IA.

Les systèmes classés à haut risque ne sont pas interdits d’usage, mais ils sont tenus de respecter des exigences plus nombreuses pour pouvoir être déployés auprès du grand public. L’une de ces exigences consiste à réaliser une évaluation de la conformité.

Téléchargez le guide, développé en partenariat avec le Future of Privacy Forum, ici.

Qu’est-ce qu’une évaluation de la conformité ?

L’article 3 du règlement de l’UE sur l’IA définit une évaluation de la conformité comme la procédure permettant de vérifier et/ou de démontrer qu’un système à haut risque est conforme à certaines exigences énoncées dans ce même règlement. Ces exigences concernent :

- Le système de gestion des risques

- La gouvernance des données

- La documentation technique

- La tenue de registres

- La transparence et la fourniture d’informations

- Le contrôle humain

- L'exactitude, la robustesse et la cybersécurité

Les fournisseurs de systèmes d’IA à haut risque doivent satisfaire ces exigences avant que leurs systèmes ne puissent être mis sur le marché. Ainsi, les individus sont protégés contre les préjudices potentiels qu’un tel système à haut risque pose. Les évaluations de conformité sont des outils clés en matière de responsabilité des systèmes à haut risque. Comprendre comment et où ils interviennent sera donc tout aussi essentiel à votre programme de gouvernance de l’IA.

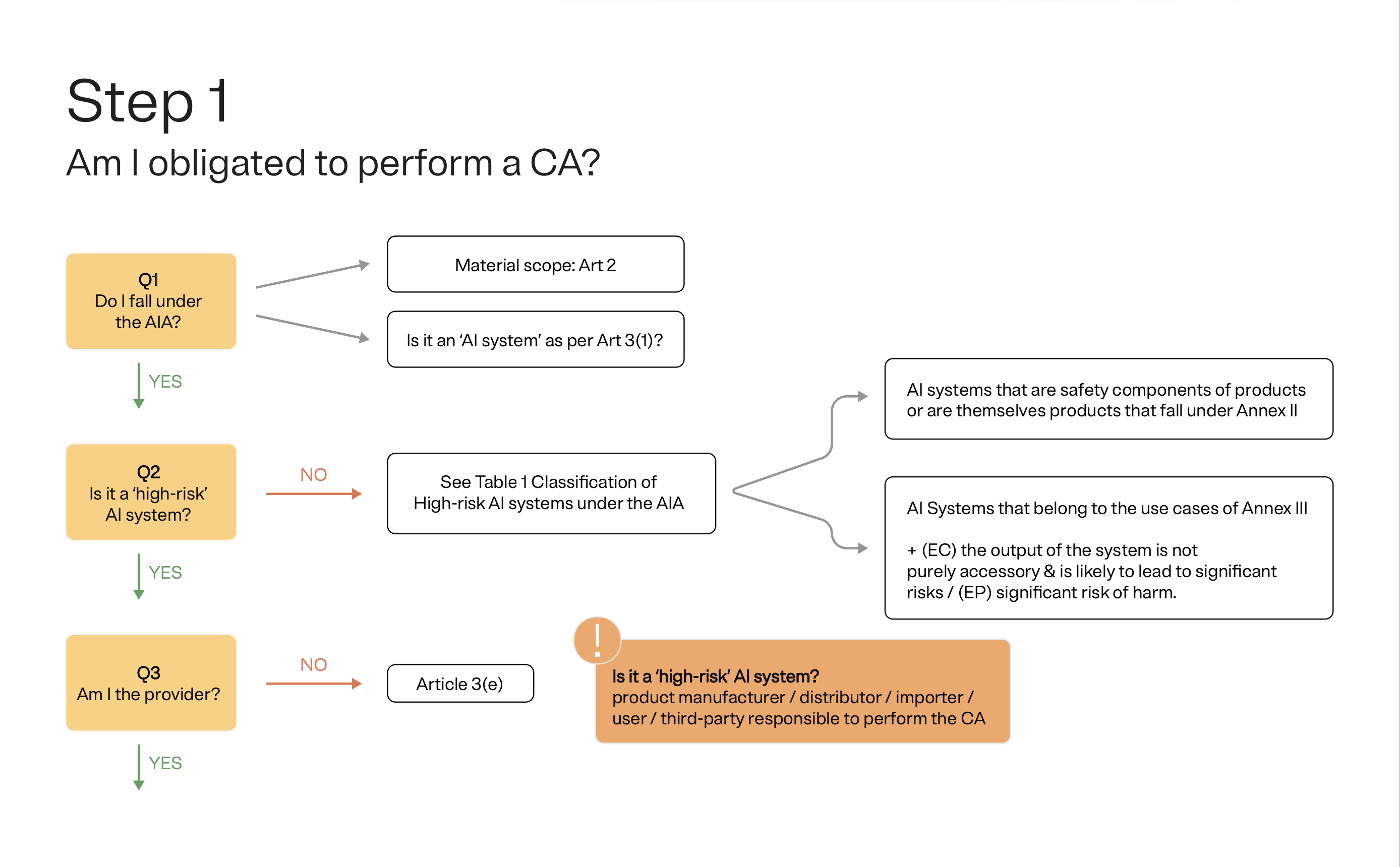

Faut-il effectuer une évaluation de conformité ?

La nécessité ou non d’effectuer une évaluation de la conformité dépend des réponses à différentes questions. Voici comment déterminer si vous avez réellement besoin d’en effectuer une :

Tout d’abord, êtes-vous soumis au règlement de l’UE sur l’IA ? Et le système d’IA que vous souhaitez utiliser est-il effectivement considéré comme un système d’IA selon l’article 3(1) du règlement ? Si ce n’est pas le cas, vous avez terminé. Vous n’avez pas besoin de faire une évaluation de la conformité. Il en va de même si votre système n’est pas considéré comme un système à haut risque. En effet, seuls les systèmes classés comme étant à haut risque selon le règlement de l’UE sur l’IA sont soumis à l’obligation de faire une évaluation de la conformité.

L’autre facteur déterminant est votre rôle au regard du système. Si vous êtes le fournisseur du système ou un acteur responsable, vous êtes responsable de la conduite de l’évaluation de conformité. Généralement, le fournisseur et l’acteur responsable sont confondus, mais il existe des exceptions.

Un acteur responsable peut être un distributeur, un importateur, un déployeur ou une autre tierce partie qui utilise l’IA sous son nom ou sa marque commerciale. Les exigences légales exactes définissant les cas où un autre acteur que le fournisseur serait tenu de réaliser l’évaluation de conformité n’ont pas encore été définies.

Quand faut-il effectuer une évaluation de conformité ?

Après avoir déterminé qu’une évaluation de la conformité doit être lancée, il est nécessaire d'établir à quel moment. En effet, les évaluations de conformité doivent être effectuées à des moments définis :

- Ex ante (avant l’événement) : l’évaluation de conformité doit être menée avant que le système d’IA ne soit mis sur le marché de l’UE, c’est-à-dire avant de le mettre à la disposition du public.

- Ex post (après l’événement) : une fois qu’un système à haut risque a été mis sur le marché, une nouvelle évaluation de la conformité est requise lorsque/si le système subit des modifications substantielles. Il convient de noter que cela ne s’applique pas aux systèmes qui continuent à apprendre (comme les modèles le font) après avoir été mis sur le marché. Ici, il s’agit plutôt de tout changement qui affecterait de manière significative la conformité du système aux exigences mesurées par l’évaluation.

Qui effectue les évaluations de conformité dans la pratique ?

Les évaluations de la conformité peuvent être réalisées en interne ou par un processus tiers. Les évaluations de la conformité internes sont menées par le fournisseur (ou l’acteur responsable) et les évaluations de la conformité tierces par un « organisme notifié » externe.

L’article 43 du règlement sur l’IA précise les directives concernant les cas nécessitant une évaluation de la conformité interne et ceux qui doivent passer par un processus tiers. Vous pouvez également trouver des étapes plus détaillées pour chaque processus dans ce guide étape par étape.

Mettre en pratique la conformité aux exigences pour les systèmes à haut risque

Comme mentionné précédemment, les évaluations de la conformité visent à vérifier que les systèmes à haut risque sont conformes aux sept exigences – gestion des risques, gouvernance des données, documentation technique, tenue des registres, obligations de transparence, contrôle humain et exactitude, robustesse et cybersécurité – énoncées dans le règlement de l’UE sur l’IA.

Sauf indication contraire, toutes ces exigences doivent être satisfaites avant que le système d’IA ne puisse être mis en service ou n’entre sur le marché. Une fois le système en utilisation, le fournisseur doit également garantir sa conformité continue tout au long de son cycle de vie.

Lors de l’évaluation de ces exigences, l’objectif prévu de l’utilisation du système doit être pris en compte, tout comme son utilisation abusive raisonnablement prévisible.

Utilisez ce guide pour approfondir chacune des exigences et voir comment la conformité et la mise en œuvre se déroulent pour chacune d’elles.

Autres ressources pertinentes

Webinaire

AI Governance

Naviguer dans la gouvernance de l’IA : Trouver l’équilibre entre conformité et innovation

Rejoignez les experts de KPMG et OneTrust pour ce webinaire de 45 minutes, où nous aborderons ces questions et partagerons des étapes concrètes pour faire fonctionner la gouvernance de l’IA dans votre organisation. Nous verrons comment passer d’initiatives isolées à une approche globale, transparente et tournée vers l’avenir.

juillet 01, 2025

Livre blanc

AI Governance

Règlement de l’UE sur l’IA : un guide pour la mise en œuvre avec OneTrust

Prêt à naviguer dans les complexités du règlement de l’UE sur l’IA ? Découvrez comment les spécialistes de la protection de la vie privée et de la sécurité défendent la conformité d’une IA responsable avec OneTrust.

avril 16, 2025

Webinaire

AI Governance

IA Act : quelle solution pour une bonne gouvernance et maîtrise des risques ?

Un webinar exclusif pour explorer les implications de la loi européenne sur l'IA et découvrir la solution AI Governance.

mars 19, 2024

Blog

AI Governance

Comprendre les niveaux de risque de l'IA Act

Le projet de loi de l'UE sur l'IA définit quatre catégories de risques pour l'utilisation des systèmes d'IA. Découvrez chacune de ces catégories et l'impact qu'elles peuvent avoir sur l'utilisation de l'IA dans votre entreprise.

mars 01, 2024 5 min de lecture

Blog

IA responsable

Ce que vous devez savoir sur les évaluations de conformité dans le cadre l’IA Act

Le projet de loi de l’UE sur l’IA adopte une approche de précaution, basée sur les risques en matière d’IA et, pour ce faire, a défini quatre catégories de risques différentes dans lesquelles les systèmes d’IA peuvent être classés.