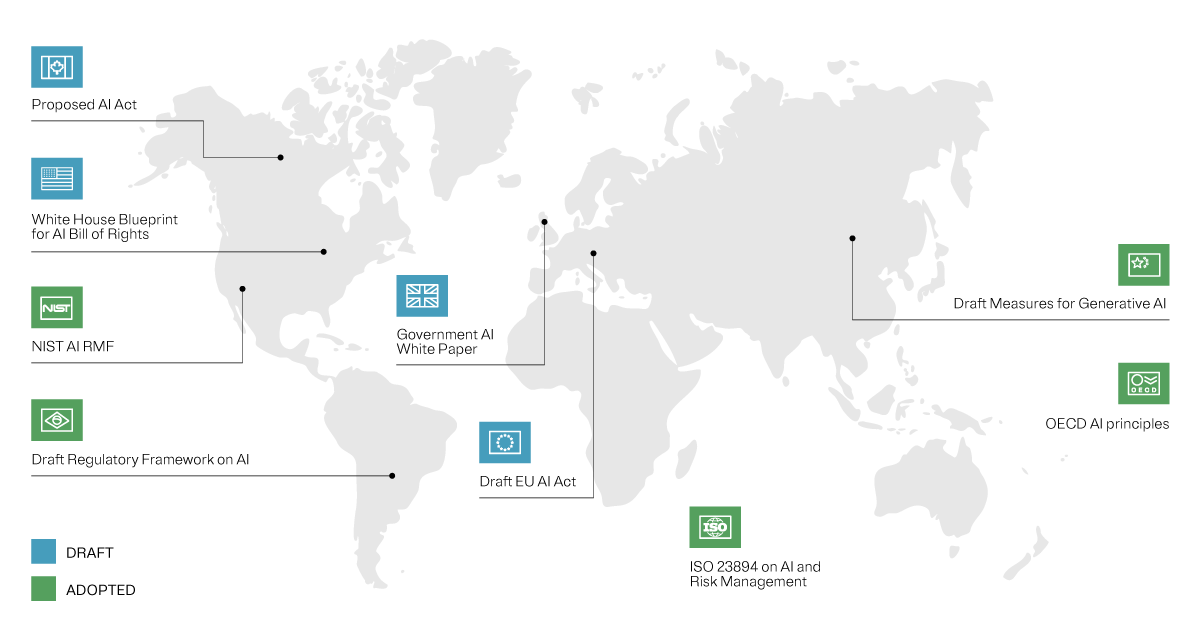

Une approche horizontale : se démarquer sur la scène mondiale

En élaborant son approche de la législation sur l’intelligence artificielle (IA), l’Union européenne (UE) a opté pour un cadre de référence législatif horizontal. Le cadre de référence juridique de l’UE en matière d’IA adopte une perspective indépendante du secteur d’activité et a été conçu en détails avec près d’une centaine d’articles.

Nous vous fournissons ici un aperçu du règlement de l’UE sur l’IA. Cette législation est la première du genre et elle constitue une référence pour réglementer l’IA dans le monde. Elle a été développée pour contribuer à la création d’un précédent dans le contexte de l’IA qui évolue rapidement.

Protéger les valeurs, stimuler l’innovation

Le règlement de l’UE sur l’IA est soigneusement équilibrée. Il ne s’agit pas seulement de jeter un filet de sécurité autour de la société, de l’économie, des valeurs et des droits fondamentaux de l’Europe qui pourraient être menacés par les systèmes d’IA ; c’est aussi une reconnaissance de la puissance et du potentiel d’innovation de l’IA, avec des garanties intégrées conçues pour promouvoir et protéger les avancées innovantes qu’elle autorise. Le règlement cherche à trouver l’équilibre entre la gestion des risques et la protection des infrastructures critiques contre les pièges potentiels, tout en promouvant les innovations que l’IA à usage général peut apporter.

L’élaboration du règlement de l’UE sur l’IA n’a pas été une promenade de santé, à commencer par la définition-même de ce qu'est l’intelligence artificielle. Depuis sa proposition de création en avril 2021, le règlement est un document vivant, qui a connu de nombreuses itérations, chaque amendement reflétant l’évolution du discours autour de la technologie de l’IA et de ses implications pour la société.

Lors de la réunion du trilogue en décembre, la France, l’Allemagne et l’Italie ont soulevé des préoccupations concernant les limitations imposées aux modèles d’IA puissants et ont souhaité alléger le régime réglementaire pour les modèles tels que GPT-4 d’OpenAI.

Après de longues discussions, la Commission européenne est parvenue à un compromis consistant à adopter une approche à plusieurs niveaux, avec des règles de transparence transversales pour tous les modèles et des obligations supplémentaires pour les modèles qui présentent un risque systémique.

Comment se positionne le règlement sur l’IA aujourd’hui

Le 2 février 2024, le Comité des représentants permanents a voté en faveur de l’accord politique conclu en décembre 2023. Le 13 mars, le Parlement a voté en faveur du Règlement, avec 523 voix pour, 46 contre et 49 abstentions.

Le règlement de l’UE sur l’IA entrera en vigueur 20 jours après sa publication au Journal officiel de l’UE. Les dispositions concernant les systèmes interdits s’appliqueront après 6 mois et les obligations pour les fournisseurs d’IA à usage général après 12 mois. La plupart des autres exigences seront applicables après deux ans.

Les systèmes à haut risque destinés à être utilisés comme composants de sécurité de produits ou qui sont couverts par d’autres lois de l’UE ont 36 mois pour se conformer au règlement de l’UE sur l’IA.

IA : décomposer le concept

À l’origine, le règlement définissait l’apprentissage automatique (ML), soit la base de tout système d’IA, comme « notamment l’apprentissage supervisé, non supervisé et par renforcement, en utilisant une grande variété de méthodes, y compris l’apprentissage profond ». Le texte donne la définition mise à jour suivante pour les systèmes d’IA : « des systèmes automatisés qui sont conçus pour fonctionner à différents niveaux d’autonomie et peuvent faire preuve d’une capacité d’adaptation après leur déploiement, et qui, pour des objectifs explicites ou implicites, déduisent, à partir des entrées qu’ils reçoivent, la manière de générer des sorties telles que des prédictions, du contenu, des recommandations ou des décisions qui peuvent influencer les environnements physiques ou virtuels ».

La complexité des systèmes d’IA est très variable, les systèmes les plus complexes nécessitant une puissance de calcul et des données d’entrée considérables. Les sorties de ces systèmes peuvent être simples ou incroyablement complexes, en fonction de la sophistication de l’IA impliquée.

Cette définition large couvre un éventail de technologies, de nos chatbots de tous les jours aux modèles d’IA générative hautement sophistiqués. Mais il est important de noter que tous les systèmes d’IA qui correspondent à la définition large du règlement n'y seront pas soumis. Le règlement joue la carte de l’intelligence en adoptant une approche basée sur le risque et en soumettant à sa réglementation uniquement les systèmes associés à des niveaux de risque spécifiques.

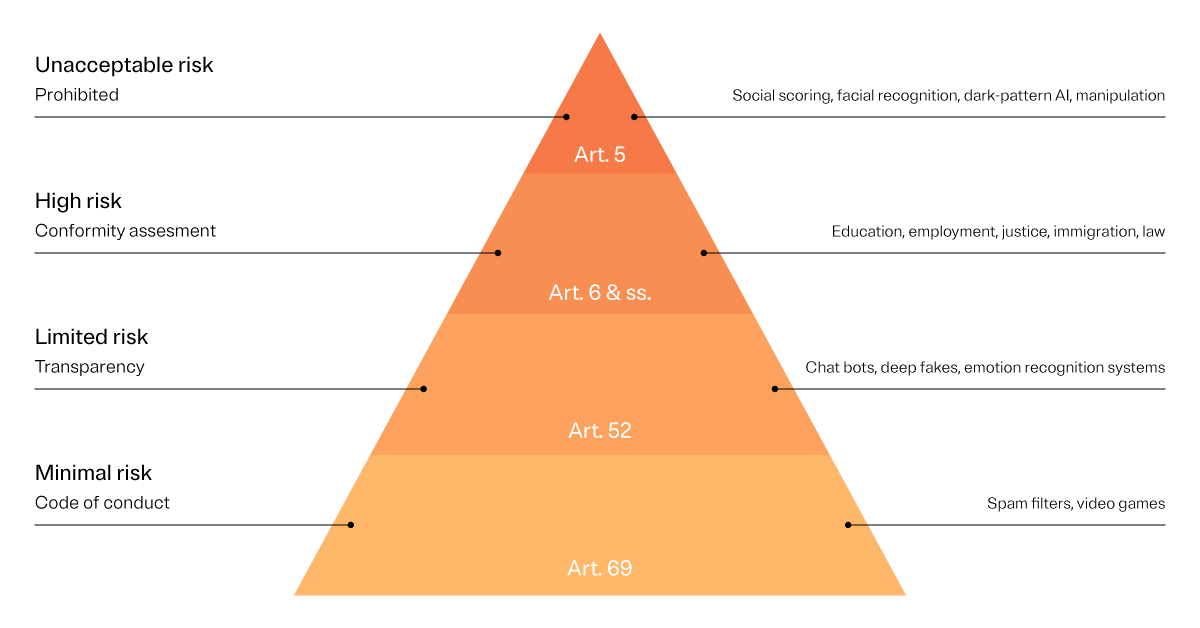

Règlement sur l’IA : un étalonnage en fonction du risque

C’est là que les choses deviennent intéressantes. Le règlement de l’UE sur l’IA classe les systèmes d’IA dans différentes catégories. Certains sont considérés comme présentant un risque inacceptable pour les valeurs européennes et sont en conséquence interdits. Les systèmes à haut risque ne sont pas interdits, mais ils sont soumis à de strictes obligations. Il est essentiel de se souvenir que ces catégories de risque ne sont pas statiques ; le règlement est encore à l’état de projet, et au fur et à mesure que des changements se produiront, ces catégories de risque seront probablement affinées.

Niveaux de risque du règlement de l’UE sur l’IA

Le règlement de l’UE sur l’IA définit plusieurs niveaux de risque qui peuvent être tolérés : risque élevé, risque limité et risque minimal.

Ce sont les niveaux de « risque admissible » qui peuvent être autorisés par les organisations. Les systèmes d’IA à « risques inacceptables » sont interdits. Si de tels systèmes sont envisagés, les entreprises doivent modifier leurs modèles pour ne pas les utiliser.