Blog

Mettre en place un comité de gouvernance de l’IA : un regard sur le processus utilisé par OneTrust

Il peut être difficile de savoir par où commencer pour créer un comité de gouvernance de l’IA. Découvrez comment OneTrust a procédé et comment vous pouvez commencer dans votre organisation

Adomas Siudika

OneTrust AI Governance Committee, Privacy Counsel, FIP

30 novembre 2023

Pour gouverner efficacement l’IA et atténuer les risques associés pour différentes populations, les organisations doivent établir des comités de gouvernance de l’IA qui mettront en place des politiques, définiront les niveaux de risque et la position de l’organisation en termes de risque, évalueront les cas d’usage et garantiront que des humains sont impliqués dans les processus à haut risque.

La plupart des organisations s’accordent à dire que les comités de gouvernance de l’IA sont essentiels à l’utilisation d’une IA responsable, mais il peut être difficile de savoir par où commencer. Dans cet article de blog, nous déroulons le processus que OneTrust a suivi pour établir son comité de gouvernance de l’IA et nous abordons les éléments que vous aurez à prendre en compte pour en créer un dans votre entreprise.

Éléments clés à rendre en compte pour créer un comité de gouvernance de l’IA

Nous sommes à ce point clé de l’évolution de l’IA où son avenir dépend fortement de la confiance qu’a le public dans les systèmes d’IA et les entreprises qui les utilisent. OneTrust s’engage pleinement à adopter et à utiliser de manière responsable des systèmes d’IA centrés sur l’humain qui respectent les valeurs fondamentales et les principes éthiques de notre entreprise et qui mettent les individus en priorité.

L’intégration progressive des systèmes d’IA dans l’ensemble de nos écosystèmes d’entreprise et leur adoption généralisée vont fondamentalement changer la façon dont nous menons nos activités. OneTrust a décidé très tôt de mettre en place un comité de gouvernance interne dédié à l’IA pour superviser ses efforts de création de son programme de gouvernance de l’IA. L’objectif de ce comité est de garantir que l’utilisation que nous faisons des systèmes d’IA aujourd’hui et demain est conforme aux principes de l’IA responsable de OneTrust, aux normes réglementaires et aux bonnes pratiques du secteur.

Qui doit participer ?

La première étape pour constituer votre comité consiste à déterminer qui devra être impliqué dans votre organisation.

Voici les questions clés à prendre en compte à cette étape :

- Qui est concerné ?

- Comment avez-vous décidé des participants ?

Le comité de gouvernance de l’IA de OneTrust est constitué de représentants des principaux domaines fonctionnels de l’organisation, notamment du service juridique, des équipes conformité, de protection de la vie privée, de sécurité de l’information, de recherche et développement, ainsi que d’ingénierie et de gestion des produits. Les membres du comité possèdent des compétences, une expérience et des antécédents divers, car nous pensons que le partage des connaissances interfonctionnelles est la clé d’un programme de gouvernance de l’IA efficace.

Pour relever les défis de la gouvernance de l’IA, il est nécessaire de faire appel à des personnes issues de spécialités diverses. Pour répondre aux nouveaux défis posés par l'innovation moderne, il faut souvent des solutions créatives qui peuvent être trouvées lorsque des personnes représentant différents domaines d'expertise se réunissent et apportent leurs points de vue uniques.

Vous assurer que vous avez un comité diversifié vous aidera à trouver les solutions créatives et les réponses réfléchies exigées par un programme de gouvernance de l’IA.

Gouvernance

Une fois que votre comité est formé, il doit gouverner. Cette étape est vaste, mais certaines des questions clés sont les suivantes :

- Comment votre organisation définit-elle les systèmes d’IA ?

- Comment définissez-vous les niveaux de risque ?

- Comment assurez-vous le contrôle humain des systèmes à haut risque ?

- Quelle est la position de votre organisation sur les systèmes d’IA générative comme ChatGPT ?

Définir l’IA est un élément essentiel des programmes de gouvernance de l’IA. On constate que les communautés de la technologie, les universitaires et les spécialistes juridiques proposent des définitions différentes pour les cerveaux numériques. Même l’IA peut être utilisée pour se définir elle-même. Lorsqu’on lui demande la définition de l’IA, ChatGPT répond : « L'intelligence artificielle (IA) désigne l'ensemble des théories, techniques et systèmes permettant à des machines de simuler des fonctions cognitives humaines pour exécuter des tâches qui nécessitent normalement de l'intelligence humaine, comme la reconnaissance vocale, la perception visuelle, la prise de décision et le traitement du langage naturel. » Cette réponse est bien articulée et souligne l’essence de ce qu’est l’IA.

Chez OneTrust, nous avons consulté les cadres réglementaires existants en matière d’IA et avons décidé d’utiliser la définition du règlement de l’UE sur l’IA. Nous considérons les nouvelles normes d'IA mises en place dans l’UE comme l'ensemble le plus avancé de normes de gouvernance de l'IA qui déterminent l'orientation des stratégies vis-à-vis de l’IA à l'échelle mondiale.

Le règlement de l’UE sur l’IA définit les systèmes d’IA comme des applications logicielles développées avec une ou plusieurs techniques ou approches intégrées telles que l’apprentissage automatique, les approches statistiques, logiques et/ou basées sur les connaissances et les méthodes d’estimation bayésienne, de recherche et d’optimisation.

Cette définition précise également qu’un système d’IA peut générer des résultats tels que du contenu, des prédictions, des recommandations ou des décisions influençant les environnements avec lesquels les humains interagissent.

Comment OneTrust définit-il les niveaux de risque liés à l’IA ?

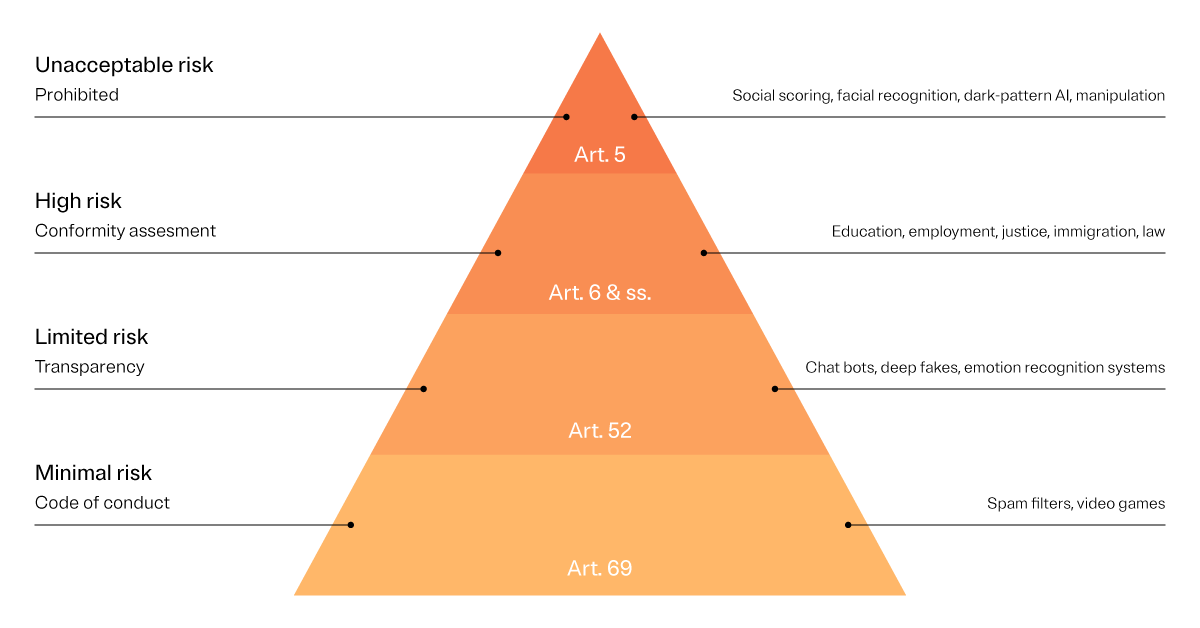

De la même façon, notre programme interne de gouvernance de l’IA adopte le système de classification des risques liés à l’IA du règlement de l’UE sur l’IA. Conformément aux orientations énoncées dans le règlement, nous classons les systèmes d’IA en quatre catégories de risque :

- Les systèmes d’IA de niveau de risque inacceptable : ces systèmes d’IA sont classés comme étant trop risqués pour être utilisés. Par exemple : la notation sociale des individus sur la base d’une surveillance dans le temps et qui peut entraîner un traitement préjudiciable ou défavorable pour eux. Ces systèmes sont interdits par le règlement de l’UE sur l’IA.

- Les systèmes d’IA à haut risque : ces systèmes d’IA présentent une forte probabilité d'atteinte à la santé et à la sécurité ou un risque d'impact négatif sur les droits fondamentaux des individus. Par exemple : le recrutement ou la sélection de candidats à l'emploi (y compris pour la publicité, la sélection ou le filtrage des candidatures, l'évaluation des candidats lors d'entretiens ou de tests), la prise de décisions en matière de promotion et de licenciement, les applications de répartition des tâches et le suivi et l'évaluation des performances et du comportement des employés.

- Les systèmes d’IA à risque limité ou minimal : il s’agit de systèmes d’IA qui ne présentent pas de risques connus d’atteinte à la santé, à la sécurité ou aux droits fondamentaux des personnes. Parmi ces systèmes, on peut citer les filtres anti-spam et les systèmes de gestion des stocks.

- Les systèmes d’IA à usage général : ce sont les systèmes d’IA qui utilisent la technologie d’IA générative (GenAI) pour créer du contenu original. Parmi ces systèmes, on peut citer les technologies qui font des résumés de contenus, créent de manière autonome des codes logiciels et génèrent des images numériques à partir du langage naturel.

Comment OneTrust garantit-il qu’une revue est faite par un humain pour les processus à haut risque ?

La politique d’utilisation de l’IA de OneTrust n’autorise pas l’utilisation des systèmes d’IA interdits. Elle définit aussi les processus d’évaluation de l’usage de toutes les autres catégories de risques. Nous utilisons les outils Third-Party Risk Management de OneTrust (TPRM) et avons développé des extensions de nos modèles d’évaluation des risques aux risques liés à l’IA. Nous pouvons ainsi évaluer les risques liés à l’IA, qui dans certains cas sont liés à d’autres normes, dans les domaines de la protection de la vie privée, de la sécurité de l’information et de l'éthique.

Bien que le processus de gestion des risques tiers soit hautement automatisé, un humain est toujours impliqué pour passer les évaluations en revue et pour intervenir en cas de problème. Nous avons développé et testons actuellement des versions modifiées en interne des analyses d’impact sur la protection de la vie privée (PIA) qui comprennent des questions sur les risques connus liés à l’IA pour évaluer les systèmes d’IA et nos fournisseurs de services d’IA.

Ces modèles prédéfinis sont un outil efficace pour identifier certains des nouveaux défis de conformité liés à l’IA, comme l’explicabilité des algorithmes de traitement des systèmes d’IA ou l’adéquation dans la divulgation d’informations personnelles traitées par les systèmes d’IA.

Les systèmes d’IA qui utilisent des données à haut risque, comme les systèmes RH qui comprennent en général un grand nombre d’informations personnelles, doivent être vérifiés par le processus d’évaluation. Cela nous permet d’obtenir le bon niveau de visibilité sur le fonctionnement de ces systèmes, les données utilisées et de vérifier que les fournisseurs ont respecté les exigences réglementaires et les bonnes pratiques de l’industrie en les développant.

Quelle est la politique et la position de OneTrust envers les outils d’IA génératifs comme ChatGPT ?

Notre politique générale est de soutenir l’utilisation des systèmes d’IA, notamment les outils d’IA génératifs, tant qu’ils sont soigneusement vérifiés et que des garanties raisonnables sont mises en place pour gérer les risques connus.

Grâce à notre processus d’évaluation des risque tiers, nous pouvons analyser tous les risques et valider l’utilisation d’outils d’IA alignés sur notre politique interne d’utilisation de l’IA, notamment sur nos principes pour une IA responsable. Plutôt que d’interdire l’utilisation de l’IA générative, nous préférons mettre en œuvre les mêmes protocoles de vérification que pour toute autre catégorie d’applications d’IA.

L’évaluation des risques pour les systèmes d’IA couvrira l’ensemble des risques associés, notamment sur la protection de la vie privée et sur l’architecture de sécurité de l’information. Avec les résultats de ces évaluations, nous décidons d’autoriser ou non l’utilisation de ces applications d’IA particulières.

Nous sommes conscients que nous ne serons peut-être pas en mesure d’éliminer complètement les risques d’IA identifiés dans tous les cas. Au lieu de cela, nous nous concentrerons sur la manière dont nous pouvons atténuer les risques connus et partager les bonnes pratiques pour les utilisateurs de ces systèmes.

Par exemple, dans la politique d’utilisation de l’IA de OneTrust à venir, nous avertissons les utilisateurs que le contenu produit par l’IA générative n’est pas entièrement fiable et peut contenir des inexactitudes et qu’il est possible que les systèmes d’IA à usage général produisent par erreur des résultats inadaptés. Nous avertissons également les utilisateurs qu'ils doivent faire preuve de prudence et de discrétion avant de partager, de publier ou d'utiliser de quelque manière que ce soit les résultats produits par les systèmes d’IA générative.

Enfin, nous informons les utilisateurs que les données produites par les systèmes d’IA ne doivent en aucun cas être utilisées pour se substituer à des conseils juridiques, financiers ou à tout autre conseil professionnel. Nous envisageons de former les utilisateurs des systèmes d’IA par le biais de formations de sensibilisation aux risques de l’IA qui font partie des mesures globales d’atténuation des risques liés à l’IA que nous déploierons auprès de notre personnel avant la fin de cette année.

Cadence et structure

Le travail de votre comité de gouvernance de l’IA sera continu, mais il est utile d’établir une cadence fixe pour les réunions régulières. Lorsque vous configurez vos processus, réfléchissez aux questions clés suivantes :

- À quelle fréquence le comité de gouvernance de l’IA se réunira-t-il ?

- Comment les réunions seront-elles structurées ?

Fréquence des réunions du comité de gouvernance de l’IA

Pour le moment, il est prévu que le comité de gouvernance de l’IA de OneTrust se réunisse tous les trimestres. Cette cadence peut être ajustée s’il y a une nécessité particulière. Cela étant dit, le comité de gouvernance de l’IA dispose d’autres moyens de mener ses activités chez OneTrust.

S'il doit prendre une décision sur une initiative ou une politique, le vote est facilité par des moyens électroniques. Actuellement, la plupart des travaux de gouvernance de l’IA sont menés dans des groupes plus petits, par exemple par les équipes de sécurité de l’information, de conformité ou de protection de la vie privée. Les réunions ad hoc en petits groupes jouent un rôle important pour nous permettre de faire avancer notre gouvernance de l’IA.

Comment les réunions sont-elles structurées ?

Les réunions du comité se concentrent sur les discussions et la prise de décision autour des principaux domaines de responsabilité, notamment la revue et la validation des projets et des initiatives liés à l’IA, le développement des politiques et des procédures de gouvernance de l’IA et le suivi de l’alignement de l’usage de l’IA sur les principes et valeurs de OneTrust pour une IA responsable.

Démarrer sa gouvernance de l’IA

Bien que la mise en place d’un programme de gouvernance de l’IA puisse sembler insurmontable au début, le fait de procéder étape par étape et de s'assurer que vous avez la bonne équipe en place permet d’avancer. Pour savoir comment OneTrust peut vous aider dans votre parcours de gouvernance de l’IA, demandez une démonstration dès aujourd’hui.

Autres ressources pertinentes

eBook

AI Governance

Élaborer un programme de gouvernance de l’IA prêt pour l’avenir : bonnes pratiques, cadres de référence éprouvés et informations d’experts pour mettre en œuvre une IA responsable | e-book

Téléchargez cet ebook pour élaborer un programme de gouvernance de l'IA claire.

novembre 24, 2025

eBook

Consent & Preferences

Établir la confiance à l’ère de l’IA : guide d’excellence pour le consentement, la protection de la vie privée et les données first-party

Découvrez comment instaurer la confiance à l’ère de l’IA avec des stratégies axées sur le consentement et la protection de la vie privée qui maximisent les données firts-party et garantissent la conformité.

octobre 08, 2025

Rapport

AI Governance

Rapport 2025 sur la gouvernance prête pour l’IA

Sur les 1 250 réponses reçues de responsables IT, un thème se démarque : la gouvernance telle qu’on la connaissait jusqu’à présent ne peut pas suivre le rythme de l’IA. Découvrez comment l’état d’esprit est en train de changer.

septembre 09, 2025

Webinaire

AI Governance

Naviguer dans la gouvernance de l’IA : Trouver l’équilibre entre conformité et innovation

Rejoignez les experts de KPMG et OneTrust pour ce webinaire de 45 minutes, où nous aborderons ces questions et partagerons des étapes concrètes pour faire fonctionner la gouvernance de l’IA dans votre organisation. Nous verrons comment passer d’initiatives isolées à une approche globale, transparente et tournée vers l’avenir.

juillet 01, 2025

Livre blanc

AI Governance

Règlement de l’UE sur l’IA : un guide pour la mise en œuvre avec OneTrust

Prêt à naviguer dans les complexités du règlement de l’UE sur l’IA ? Découvrez comment les spécialistes de la protection de la vie privée et de la sécurité défendent la conformité d’une IA responsable avec OneTrust.

avril 16, 2025

Webinaire

AI Governance

IA Act : quelle solution pour une bonne gouvernance et maîtrise des risques ?

Un webinar exclusif pour explorer les implications de la loi européenne sur l'IA et découvrir la solution AI Governance.

mars 19, 2024

eBook

AI Governance

Un guide à destination des fournisseurs et des déployeurs d'IA

Ce playbook contient toutes les informations dont vous avez besoin pour comprendre vos obligations en matière d'intelligence artificielle (IA).

mars 12, 2024

Blog

AI Governance

Comprendre les niveaux de risque de l'IA Act

Le projet de loi de l'UE sur l'IA définit quatre catégories de risques pour l'utilisation des systèmes d'IA. Découvrez chacune de ces catégories et l'impact qu'elles peuvent avoir sur l'utilisation de l'IA dans votre entreprise.

mars 01, 2024 5 min de lecture

Blog

AI Governance

Ce que le Code de conduite du G7 signifie pour votre entreprise

Les systèmes d’IA avancés deviennent monnaie courante, annonçant des avancées potentielles et, à l’inverse, des risques. Reconnaissant l’immense impact de l’IA, le Code du G7 est le dernier d’une série de développements récents et à venir concernant les orientations autour de l’IA.